Распространение фальшивых новостей — это лишь первая волна фейкового контента, нашествие которого стоит ожидать в ближайшие годы. Генеративные нейросети (GAN) уже позволяют создавать видеоролики, на которых люди делают то, чего не делали, и говорят то, что никогда не говорили. Журнал The Economist объясняет, как устроен новый мультимедийный мир, в котором ничему нельзя доверять.

... Генеративные нейросети могут вывести фальшивые новости на новый уровень, в котором фейковые видеоролики и аудиодорожки нельзя будет отличить от настоящих. Принцип работы GAN-систем прост. Нейросети изучают статистические характеристики аудиозаписи, а затем воспроизводят их в другом контексте. При этом они улавливают изменения в речи с точностью до миллисекунды. Достаточно ввести текст, который нейросеть должна воспроизвести, и получится правдоподобное выступление, например, Трампа или другого политика. Хотя на самом деле никакого выступления не было.

В апреле канадский стартап Lyrebird опубликовал набор алгоритмов, которые могут сымитировать голос любого человека. Для обучения системе достаточно прослушать звуковой файл длиной не больше 1 минуты. Алгоритм не только имитирует голос, но и может добавлять нужную эмоциональную окраску. «Фотошоп» для речи также представила компания Adobe. Аудиоредактор вырезает произнесенные слова и вставляет на их место новые.

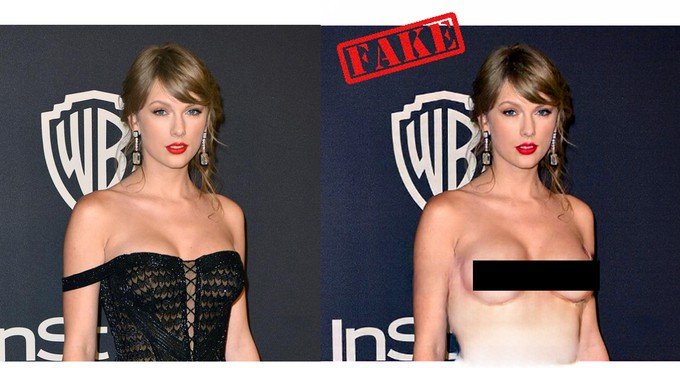

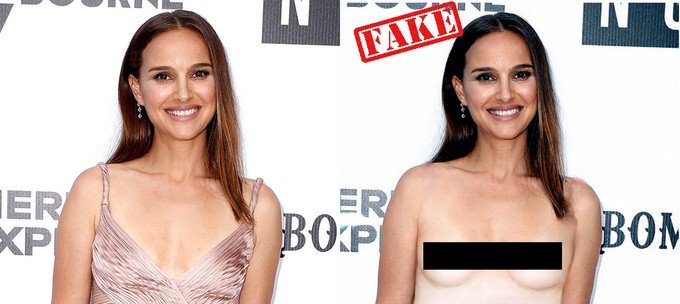

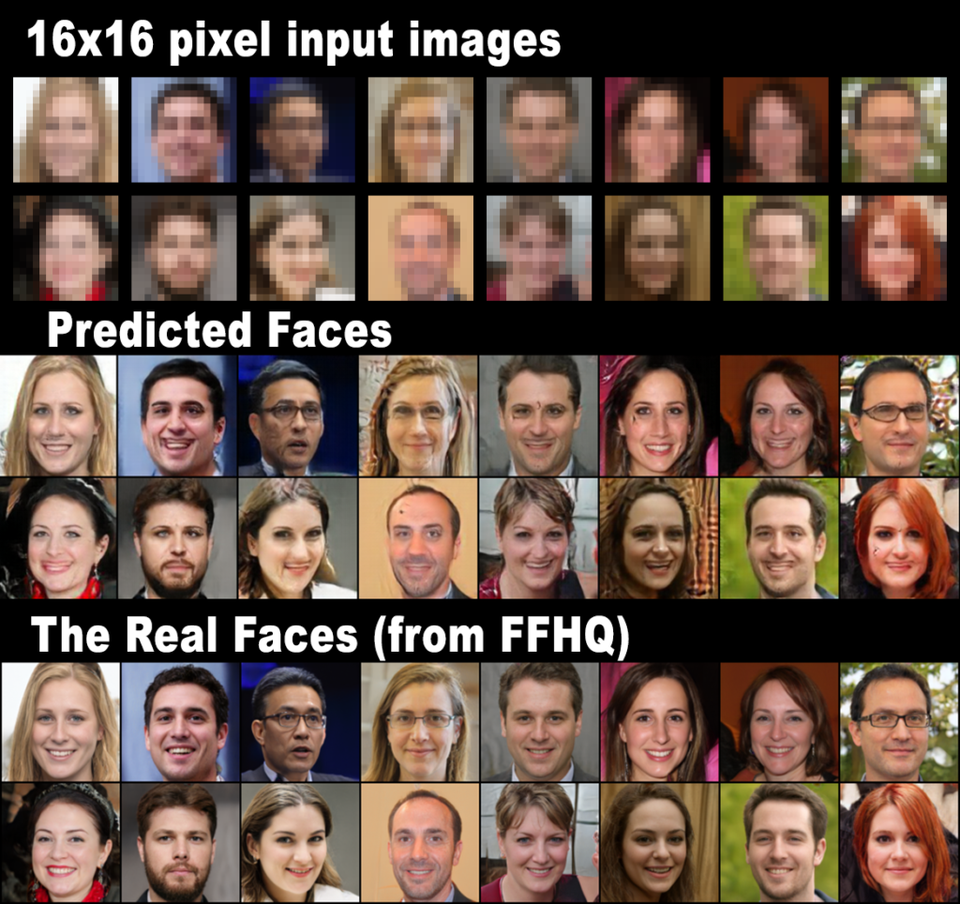

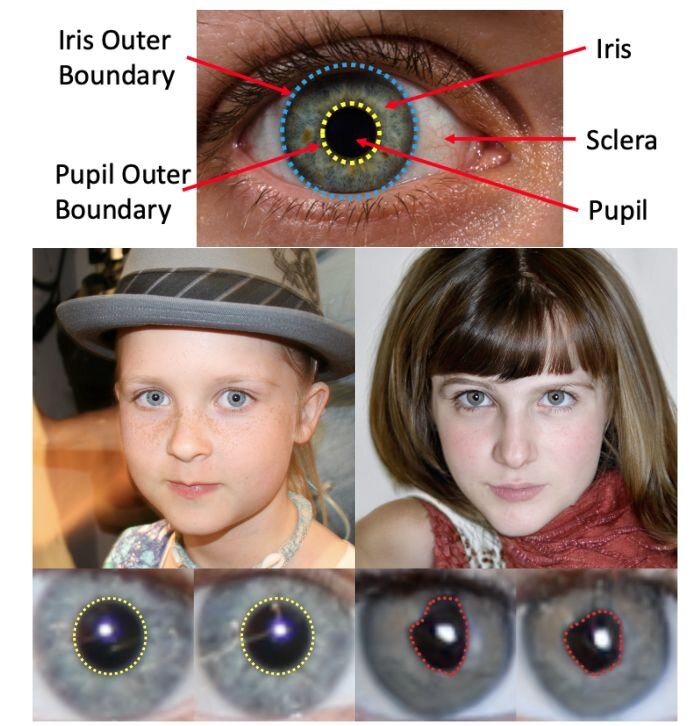

Генерирование изображений пока дается нейросетям сложнее. Даже после просмотра сотен картинок с собаками и кошками, нейросеть не может нарисовать убедительное вымышленное животное. Созданные ученым Яном Гудфеллоу GAN-системы изменили ситуацию. При запуске GAN одна нейросеть пытается обмануть другую, имитируя реальное изображение. Вторая нейросеть при этом контролирует процесс и сопоставляет генерированный контент с реальной базой изображений.

GAN уже удается по описанию составить довольно точный «фоторобот» птицы, хоть и небольшого размера. К тому же системы постоянно совершенствуются. По прогнозам Гудфеллоу, через три года YouTube заполнят фейковые ролики. Другие эксперты считают, что на налаживание процессов медиафальсификации уйдет больше времени, но рано или поздно это точно произойдет.

Программа Face2Face уже позволяет переносить движения, мимику и фразы любого пользователя на видеоролик с другим человеком. Разработчики, например, показали, как можно удаленно поменять выражение лица Трампа на видео с помощью ПО.

Со временем в арсенале каждого интернет-пользователя окажется устройство для верификации контента. Это может быть программа для изучения метаданных или система, которая исследует задний план фото или видео, сопоставляя местность с данными на Google Earth. Защититься от нашествия фейков поможет и шифрование.

https://hightech.fm/2017/07/07/fake_spread

... Генеративные нейросети могут вывести фальшивые новости на новый уровень, в котором фейковые видеоролики и аудиодорожки нельзя будет отличить от настоящих. Принцип работы GAN-систем прост. Нейросети изучают статистические характеристики аудиозаписи, а затем воспроизводят их в другом контексте. При этом они улавливают изменения в речи с точностью до миллисекунды. Достаточно ввести текст, который нейросеть должна воспроизвести, и получится правдоподобное выступление, например, Трампа или другого политика. Хотя на самом деле никакого выступления не было.

В апреле канадский стартап Lyrebird опубликовал набор алгоритмов, которые могут сымитировать голос любого человека. Для обучения системе достаточно прослушать звуковой файл длиной не больше 1 минуты. Алгоритм не только имитирует голос, но и может добавлять нужную эмоциональную окраску. «Фотошоп» для речи также представила компания Adobe. Аудиоредактор вырезает произнесенные слова и вставляет на их место новые.

Генерирование изображений пока дается нейросетям сложнее. Даже после просмотра сотен картинок с собаками и кошками, нейросеть не может нарисовать убедительное вымышленное животное. Созданные ученым Яном Гудфеллоу GAN-системы изменили ситуацию. При запуске GAN одна нейросеть пытается обмануть другую, имитируя реальное изображение. Вторая нейросеть при этом контролирует процесс и сопоставляет генерированный контент с реальной базой изображений.

GAN уже удается по описанию составить довольно точный «фоторобот» птицы, хоть и небольшого размера. К тому же системы постоянно совершенствуются. По прогнозам Гудфеллоу, через три года YouTube заполнят фейковые ролики. Другие эксперты считают, что на налаживание процессов медиафальсификации уйдет больше времени, но рано или поздно это точно произойдет.

Программа Face2Face уже позволяет переносить движения, мимику и фразы любого пользователя на видеоролик с другим человеком. Разработчики, например, показали, как можно удаленно поменять выражение лица Трампа на видео с помощью ПО.

Со временем в арсенале каждого интернет-пользователя окажется устройство для верификации контента. Это может быть программа для изучения метаданных или система, которая исследует задний план фото или видео, сопоставляя местность с данными на Google Earth. Защититься от нашествия фейков поможет и шифрование.

https://hightech.fm/2017/07/07/fake_spread

очень смешно получилось

очень смешно получилось